虽然翻墙工具有成百上千个,但是如果把它们分类,绝大部分都是 Proxy、SSH 和 VPN 这三类。

那么,Proxy、SSH 和 VPN 之间有什么区别呢?谁的安全性最高呢?

如果把传输的信息看作一个包裹,那么我们就可以用三个简单的比喻来做比较。

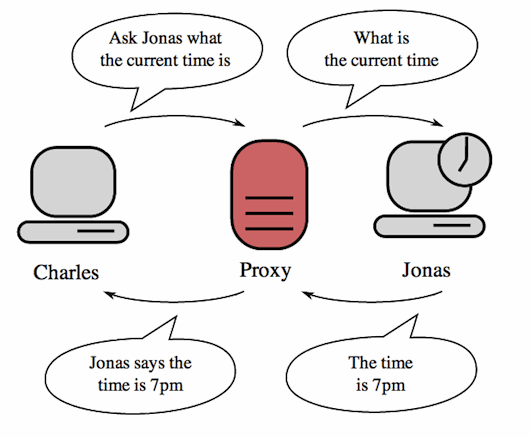

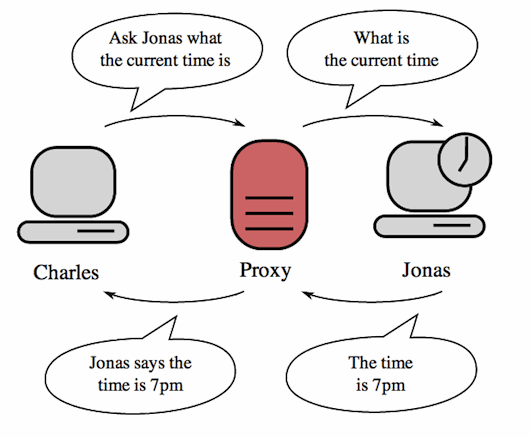

1、Proxy

Proxy、SSH 和 VPN 的区别

Proxy、SSH 和 VPN 的区别

Proxy (代理),可以看作是一个快递员,负责将你的包裹送达收件人。

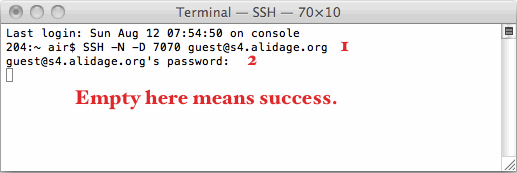

2、SSH

Proxy、SSH 和 VPN 的区别

Proxy、SSH 和 VPN 的区别

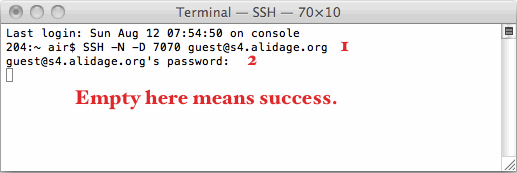

SSH (Secure Shell, 安全外壳协议)是一种加密渠道,本身并不能翻墙,需要结合代理服务器才能够翻墙。所以,我们通常所说的用来翻墙的 SSH,都是指 SSH 代理。

也就是说,SSH 代理 = 代理 + SSH,可以看作是加密了的代理,就好比把包裹装在保险箱里面再交给快递员。

3、VPN

Proxy、SSH 和 VPN 的区别

Proxy、SSH 和 VPN 的区别

图片来源: http://en.wikipedia.org/wiki/Virtual_private_network

而使用 VPN(Virtual Private Network,虚拟私人网络),就好比不通过快递员,你亲自把包裹交给收件人所在公司的前台,再由前台转交给收件人。

从以上三个比喻可以看出,VPN 的安全性要高于 SSH、而 SSH 又高于 Proxy,因为相对来讲,包裹中途被拦截的几率要比目的地的高,特别是当大家都是在同一个服务器上搭建的时候,但是大多数情况下,这三类翻墙工具都是不 在同一个服务器上的,所以安全性也是相对的。

另外,Proxy 和 SSH 的作用是局部的,只适用于你指定的应用程序(例如浏览器),而 VPN 的作用是全局的,适用于你的整台设备,不管是浏览器、邮件客户端、iTunes 或者其他任何的连接到互联网的应用程序。

还有,通过 Proxy 和 SSH 翻墙的时候,需要设置网络的代理地址,而 VPN 则不需要。

原文:http://jingpin.org/proxy-ssh-vpn/

参考:什么是 VPN?

本文:Proxy、SSH 和 VPN 的区别

Related Posts

Google adwords新手推广常见错误Google adwords是很多外贸公司常用的推广方式之一,由于Google在搜索引擎领域的江湖地位,它的SEM还是很有效果的。不过很多新手在操作时,往往会出现这样那样的错误,流失的可都是白花花的银子啊。下面这10个错误是Goolgle adwords新手常犯的,要尽量避免。 1.使用Content Network (adsense) Content Network会带来可能欺诈性和非目标明确性的点击,所以开始时候要把Content…

下载YouTube视频字幕的方法YouTube跟国内的优酷、土豆等视频网站比起来不仅广告时间短、可以“跳过广告”播放,而且很多视频上提供了字幕,有些视频甚至提供了20多种 语言的字幕。因为YouTube在国内是无法访问的,我经常会想着把一些YouTube上的视频下载下来,上传到国内的视频网站上供大家分享,但发现有个 问题,YouTube上的字幕和视频是独立的,没有合成到一起,所以,下载下来的视频是不含字幕的。这当然不行的,英语无字幕的视频估计没有几个人会喜 欢。那么,如何能把字幕也下载下来呢? YouTube的视频我是用了一个火狐浏览器的插件下载的,所以我就搜索有没有可以下载字幕的插件,果然找到了一个,YouTube Caption Downloader,但这个插件看起来在我的最新版本的火狐浏览器上是没有起作用,我看不到应该出现的下载按钮。然后我有找到了几个声称可以下载YouTube字幕的桌面小工具,比如4K Video Downloader和Google2SRT,但这些工具很简单,没有提供设置代理服务器翻墙的地方,所以,直接使用它们是连接不到YouTube网站的。…

如何防止网站关键数据被人恶意采集昨天晚上花了几个小时用Jsoup写了一个网站采集器,帮一个高中同学采集了一个工业信息门户上的芯片待售信息。网站上显示的数据多达60w+条, 我写的程序跑了7个小时只采集了一半,算是可以交差了。 这已经是我第二次写这种采集器了。之前在做波菜网的时候,写过一个更复杂的。当时网站上线以后苦于没有原生态的内容,我就写了一个采集器从“百度身边”采集各大城市的餐馆和菜品信息,并通过google地图的接口获取餐馆的地理位置,然后转存到我们自己的网站上。 我必须承认,做这些事儿都是不光彩的,属于不劳而获,弄不好还得背上法律责任。但是在国内这个互联网的环境下,这种小规模的数据采集想上升到法律层面去禁止,还是不切实际的。那么从一个网站的开发或者运营的角度,如何来防范别人的恶意采集呢?如何做到在防范的同时又不影响搜索引擎的蜘蛛的采集工作呢? 从我个人的采集经验来看,我觉得这种防御可以从两个方面着手。 服务器端的配置。至少可以通过防火墙来屏蔽某些ip的高频率访问,或者在web服务器设置规则来禁止关键页面被某些ip高频请求。也可以先通过防火墙设置预警机制,一旦发现异常立即通知web服务器采取屏蔽措施。不管是专业的采集器还是像我的这种纯代码级别的采集,最基本的原理就是模拟用户浏览网站行为,发送http请求到网站的server,然后解析返回的结果。出于效率起见这种采集行为都有几个共同的特点。一是发出请求的ip地址比较固定,二是请求的频率比较稳定,三是访问的页面也比较固定。防火墙的设置可以基于前面两个特征,web服务器的过滤规则可以基于后面两个特征。当然这些措施只是从物理层面的防御,放不了真正的高手。我在我的采集器里面实现的多线程采集,就会把采集频率用随机时间来控制,也就是发送采集请求的频率是随机的,有可能是3秒钟一次,有可能是2秒钟一次。另外如果我是黑客,我可以发动多个ip的肉机来发送请求。总之一句话,服务器上的防御,防得了君子,防不了高级的小人,但是有总比没有好。 代码级别的防御。采集器可以模拟浏览器大部分的行为,但是肯定有模仿不到的地方。比如说带参数的ajax请求。从我的经验来看,你至少可以在通过以下三种方式来优化你的代码,以防止恶意采集。 1> 关键信息通过ajax请求来获取,最好是需要带有临时token作为参数的请求。网站在发布的时候需要做javascript代码压缩和混淆,这样程序人员就很难通过阅读代码或者捕获请求来建立模拟采集。这里说的关键信息,是指那种对业界同行来说比较重要的信息,比如说价格等。除了这些关键信息以为的信息就最好不要用ajax请求来显示了,那样不利于SEO优化,搜索引擎的蜘蛛也不能模拟如此复杂ajax请求。另外如果有分页,一定要用ajax请求来分页。具体例子可以看看花瓣网的首页。至于通过表单请求来获取数据,有些采集器已经能模拟带session或者cookie信息的表单请求了,至少Jsoup是可以做到的。…

![]()